xAI 的 Grok 现已开源。

代码: 链接

博客: 链接

基础模型基于大量文本数据进行训练,未针对任何特定任务进行微调。

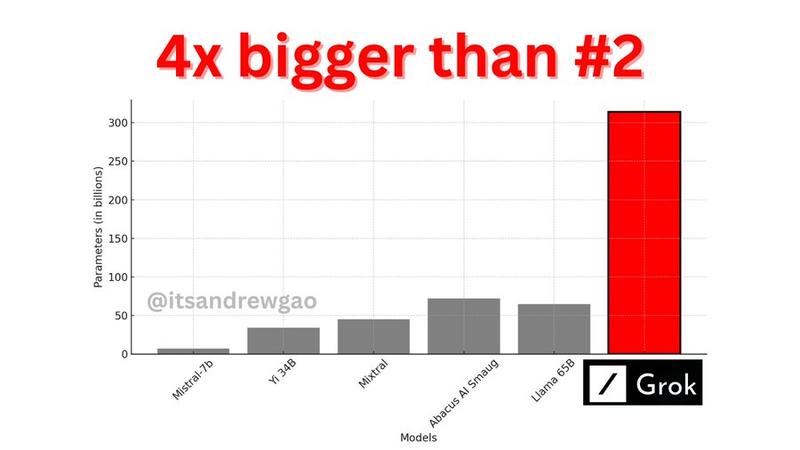

3140亿 参数混合专家模型,其中 25% 的权重在给定Token上处于活动状态。

xAI 于 2023 年 10 月使用基于 JAX 和 Rust 的自定义训练堆栈从头开始训练。

---

来自英伟达科学家@DrJimFan的评价:

有史以来最大的开放LLM,由世界级团队训练,通过磁力链接发布。Apache 2.0。

314B,专家混合(8 个活跃中的 2 个)。就连活动参数仅(86B)就超过了最大的Llama。迫不及待地想看到基准测试结果以及人们用它构建的内容。

链接